将来は、アバターを介して小鳥との会話が可能に?

———現在、先生たちが取り組んでいるさえずり研究について教えてください。

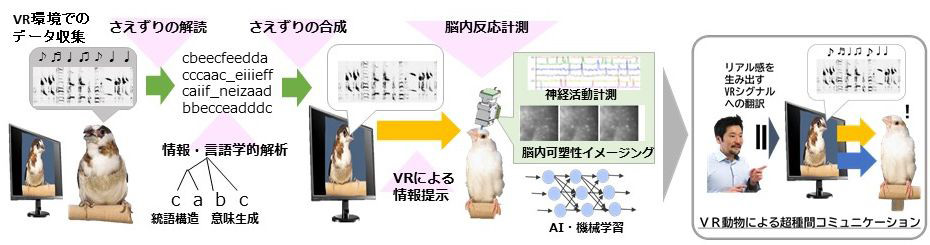

小鳥たちがどういう状況でどういうさえずりを使うのかを調べるために、モニターで小鳥にいろいろなVR(ヴァーチャル・リアリティ)の映像を見せるんです。映し出された映像の状況に応じて鳥がいろいろなさえずりを発するので、その音声データを大規模に集めてテキスト化し、文法構造などを解析していきます。

———いったいどんな映像を見せるのですか?

例えば、仲間同士が喧嘩している映像だとか、モニターの鳥にはエサがいっぱいあるのにこちらにはないとか。ヘビが出てきたり、仲間のところにカラスがやってきたりする映像など、いろいろ用意しています。

———小鳥はモニターを見てちゃんと反応するんですか?

鳥の仲間は紫外線も見えますし、ヒトと同じように見えているわけではないでしょうが、いろいろ試してみたところ、小鳥はモニターを見て、本当に仲間がいるようなふるまいをするんです。そこに至るまでにはけっこう苦労していろいろなノウハウがあるんですけど、VR映像に応じてどんなさえずりを使うかということが次第に明らかになってきました。

本当に鳥たちがモニター上の映像を、生きている鳥と同じように認識してコミュニケーションしているかどうかは脳の活動を見ればわかりますし。

VR映像に反応するジュウシマツ。モニタ内で仲間が仲良く過ごしている様子に反応し、発する音声を随時記録して解析する。

注:動画に音声は入っていない。

VR親に反応するさえずり学習中のキンカチョウ雛

注:動画に音声は入っていない。

———鳥たちの脳の活動はどのように見ていくのでしょう? 鳥の脳に電極を刺したりするんでしょうか?

ぼくたちのラボでやっているのは、脳の中の神経細胞の活動を光で観察するという神経活動イメージングです。小さい蛍光顕微鏡を頭に装着してやると、他の鳥のさえずりを聞かせているときに特定のタイミングで神経細胞が光って活動していることがわかります。2011年の論文のときは、行動を観察していたのですが、鳥が反応しているときの脳活動を客観的に把握できるようになったわけです。

———それはすごい! ほかにもツールはいろいろ進歩しているんでしょうね。

さきほど、鳥たちのさえずりをテキスト化するとお話ししましたが、人工知能(AI)を活用して、鳥たちが何かしゃべったら、それをほぼリアルタイムでテキスト文字列に翻訳するプログラムを開発しました。逆にテキストからさえずりを合成することもできます。aという音をbという音に置き換えるとか、任意の音の並びからなる人工的なさえずりが自在に作れるので、それを聞かせたときの鳥の神経活動を解析することもできるというわけです。

人工合成音に対する鳥の反応を同時にアルファベットの文字列にしている。

———10年前は、研究者がスペクトラム表示の波形を見て、これはaでこれはbというふうに分類していたのを、AIが瞬時にテキスト化しているということですか。

最初はスペクトラム画像と音声のマッチングをさせていたんですが、今やっているのは次世代のやり方で、スペクトラムに依存せずに、膨大なデータを用いてAIに音素の特徴成分を学習させることで、自動的にその特徴を抽出してテキスト化しています。

こうして集めた膨大なテキストデータを使って、ジュウシマツの多彩なさえずりがどんな言語構造を持っているかや、どんな状況でどのパターンの音がよく使われるかといったことを調べようと、同じ東北大学で人工知能や自然言語処理の専門家の先生や、言語学の先生と一緒に研究を進めているところです。

———研究が進めば、やがて小鳥の気持ちを理解することも可能になるでしょうか?

ヒトと小鳥が直接話すことはできないにしろ、人工さえずりを使うアバターを介して、生きている動物と会話ができるようになるかもしれません。